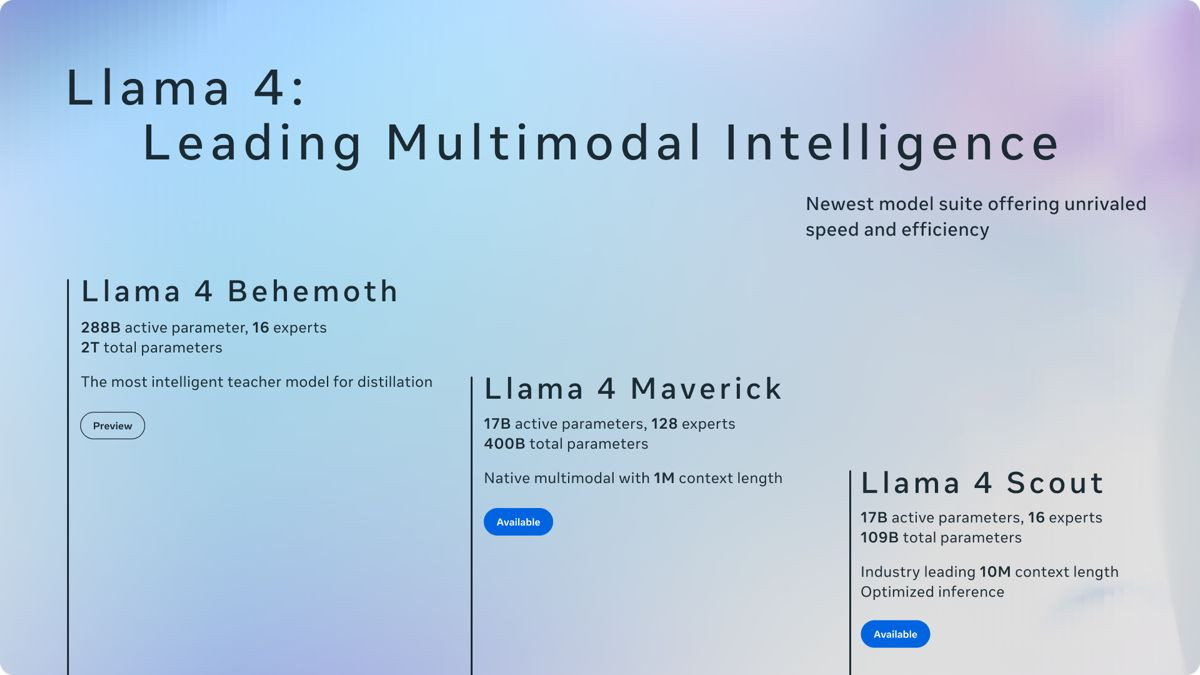

Η Meta κυκλοφόρησε τη νέα γενιά AI μοντέλων με ονομασία Llama 4, η οποία περιλαμβάνει τα Llama 4 Scout, Llama 4 Maverick και Llama 4 Behemoth. Όλα εκπαιδεύτηκαν σε «μεγάλες ποσότητες ανώνυμων δεδομένων κειμένου, εικόνας και βίντεο» για να αποκτήσουν «ευρεία οπτική κατανόηση», σύμφωνα με την εταιρεία.

Η επιτυχία των ανοικτών μοντέλων της κινέζικης DeepSeek, τα οποία αποδίδουν ισάξια ή καλύτερα από την προηγούμενη ναυαρχίδα των μοντέλων Llama της Meta, φέρεται να ταρακούνησε την τελευταία, καθώς έστησε εξειδικευμένες ομάδες προκειμένου να αποκρυπτογραφήσουν πώς η DeepSeek κατάφερε να μειώσει το κόστος λειτουργίας και ανάπτυξης μοντέλων όπως το R1 και το V3.

Τα Scout και Maverick είναι ανοιχτά διαθέσιμα στο Llama.com και από τους συνεργάτες της Meta, συμπεριλαμβανομένης της πλατφόρμας Hugging Face, ενώ το Behemoth βρίσκεται ακόμη σε στάδιο εκπαίδευσης. Η Meta αναφέρει ότι το Meta AI, ο AI βοηθός της σε εφαρμογές όπως το WhatsApp, το Messenger και το Instagram, έχει ενημερωθεί ώστε να χρησιμοποιεί το Llama 4 σε 40 χώρες. Τα πολυτροπικά χαρακτηριστικά περιορίζονται προς το παρόν στις ΗΠΑ στα αγγλικά. Ωστόσο, ορισμένοι προγραμματιστές μπορεί να έχουν πρόβλημα με την άδεια χρήσης του Llama 4.

Οι χρήστες και οι εταιρείες που «κατοικούν» ή έχουν «κύρια έδρα» στην ΕΕ απαγορεύεται να χρησιμοποιούν ή να διανέμουν τα μοντέλα, πιθανότατα ως αποτέλεσμα των απαιτήσεων διακυβέρνησης που επιβάλλονται από τους νόμους της περιοχής για την τεχνητή νοημοσύνη και την προστασία των δεδομένων. Επιπλέον, όπως και με τις προηγούμενες εκδόσεις του Llama, οι εταιρείες με περισσότερους από 700 εκατομμύρια μηνιαίως ενεργούς χρήστες πρέπει να ζητήσουν ειδική άδεια από τη Meta, την οποία η Meta μπορεί να χορηγήσει ή να αρνηθεί κατά τη διακριτική της ευχέρεια.

Η Meta αναφέρει ότι το Llama 4 είναι η πρώτη ομάδα μοντέλων της που χρησιμοποιεί μια αρχιτεκτονική μίξης εμπειρογνωμόνων (MoE - Mixture of Experts), η οποία είναι πιο αποδοτική από υπολογιστική άποψη για την εκπαίδευση και την απάντηση ερωτημάτων. Οι αρχιτεκτονικές MoE ουσιαστικά αναλύουν τις εργασίες επεξεργασίας δεδομένων σε επιμέρους εργασίες και στη συνέχεια τις αναθέτουν σε μικρότερα, εξειδικευμένα μοντέλα «ειδικών».

Το Maverick, για παράδειγμα, έχει 400 δισεκατομμύρια συνολικές παραμέτρους, αλλά μόνο 17 δισεκατομμύρια ενεργές παραμέτρους που διανέμονται σε 128 «ειδικούς». Το Scout έχει 17 δισεκατομμύρια ενεργές παραμέτρους, 16 ειδικούς και 109 δισεκατομμύρια συνολικές παραμέτρους.

Σύμφωνα με τις εσωτερικές δοκιμές της Meta, το Maverick, το οποίο η εταιρεία λέει ότι είναι καλύτερο για περιπτώσεις χρήσης «γενικού βοηθού και συνομιλίας», όπως η δημιουργική γραφή, ξεπερνά μοντέλα όπως το GPT-4o του OpenAI και το Gemini 2.0 της Google σε ορισμένα σημεία αναφοράς κωδικοποίησης, συλλογισμού, πολυγλωσσίας, μακράς διάρκειας και εικόνας. Ωστόσο, το Maverick δεν μπορεί να συγκριθεί με πιο ικανά πρόσφατα μοντέλα όπως το Gemini 2.5 Pro της Google, το Claude 3.7 Sonnet της Anthropic και το GPT-4.5 του OpenAI.

Τα δυνατά σημεία του Scout βρίσκονται σε εργασίες όπως η περίληψη εγγράφων και η συλλογιστική πάνω σε μεγάλες βάσεις κώδικα. Το Scout μπορεί να δέχεται εικόνες και έως και εκατομμύρια λέξεις, επιτρέποντάς του να επεξεργάζεται και να εργάζεται με εξαιρετικά μακροσκελή έγγραφα, ενώ μάλιστα μπορεί να τρέξει σε μία μόνο Nvidia H100 GPU.

Από την άλλη, το Maverick απαιτεί ένα σύστημα από Nvidia H100 DGX ή ισοδύναμο, ενώ το Behemoth όταν θα είναι έτοιμο θα χρειαστεί ακόμη πιο ισχυρό hardware. Σύμφωνα με την εταιρεία, το Behemoth έχει 288 δισεκατομμύρια ενεργές παραμέτρους, 16 ειδικούς και σχεδόν δύο τρισεκατομμύρια συνολικές παραμέτρους. Σύμφωνα με την εσωτερική συγκριτική αξιολόγηση της Meta, το Behemoth ξεπερνάει τα GPT-4.5, Claude 3.7 Sonnet και Gemini 2.0 Pro (αλλά όχι το 2.5 Pro) σε διάφορες αξιολογήσεις που μετρούν δεξιότητες STEM, όπως η επίλυση μαθηματικών προβλημάτων.

Να σημειωθεί ότι κανένα από τα μοντέλα του Llama 4 δεν είναι ένα κατάλληλο μοντέλο «συλλογισμού» κατά τα πρότυπα των o1 και o3-mini του OpenAI. Τα μοντέλα συλλογισμού ελέγχουν τις απαντήσεις τους και γενικά απαντούν σε ερωτήσεις με μεγαλύτερη αξιοπιστία, αλλά κατά συνέπεια χρειάζονται περισσότερο χρόνο από τα παραδοσιακά, «μη συλλογιστικά» μοντέλα για να δώσουν απαντήσεις.

[via]