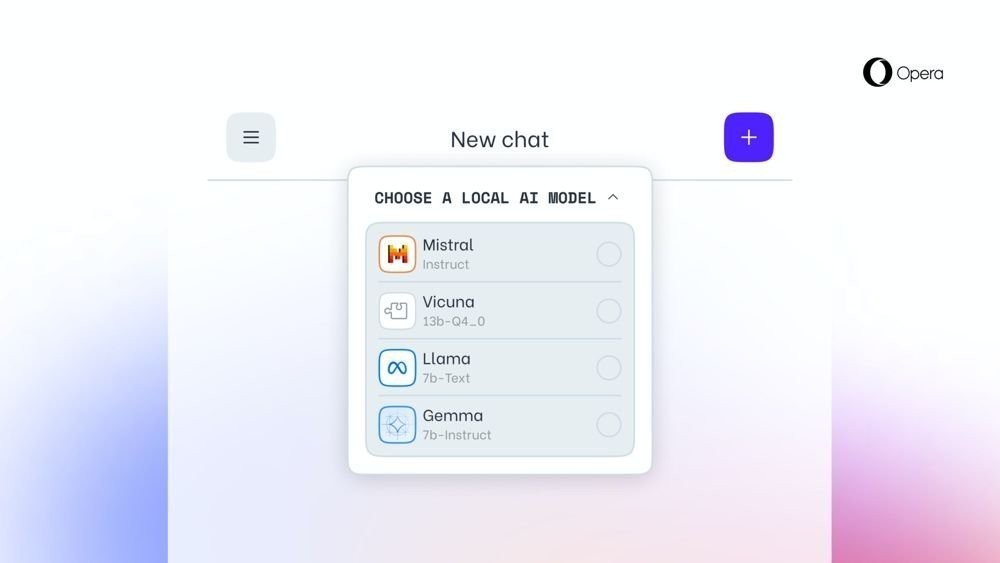

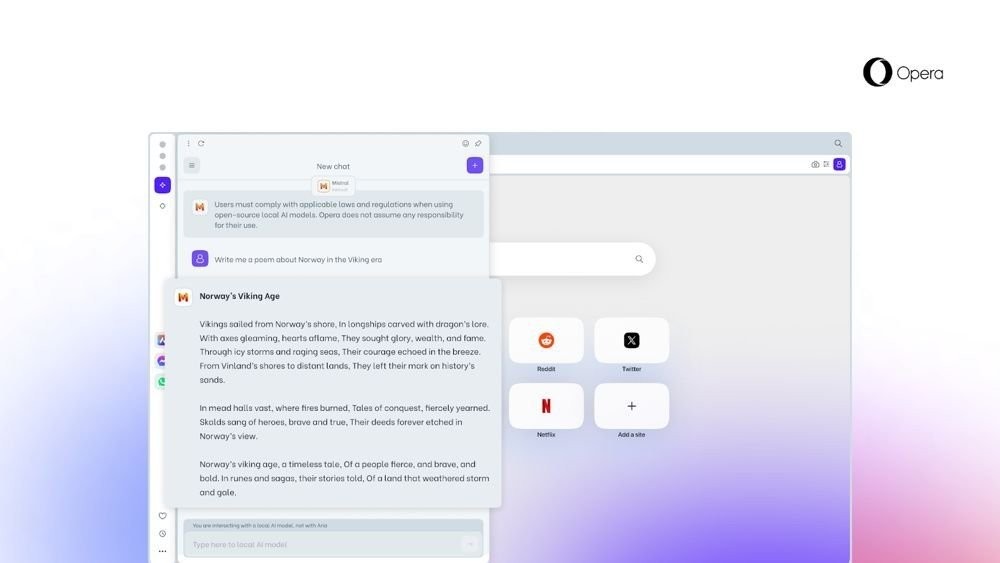

Η Opera εισήγαγε μια νέα λειτουργία που θα επιτρέπει στους χρήστες να κατεβάζουν και να χρησιμοποιούν μεγάλα γλωσσικά μοντέλα (Large Language Models - LLMs) τοπικά στον υπολογιστή τους. Η λειτουργία είναι διαθέσιμη στους χρήστες του Opera One που λαμβάνουν ενημερώσεις για προγραμματιστές. Έτσι, οι χρήστες μπορούν να έχουν πρόσβαση σε πάνω από 150 μοντέλα από περισσότερες από 50 οικογένειες, όπως το Llama από τη Meta, το Gemma από τη Google, το Vicuna, το Mistral AI και άλλα.

Ο Krystian Kolondra, EVP of Browsers and Gaming στην Opera, δήλωσε:

Η εισαγωγή των τοπικών LLMs με αυτόν τον τρόπο επιτρέπει στην Opera να αρχίσει να διερευνά τρόπους δημιουργίας εμπειριών και τεχνογνωσίας στον ταχέως αναδυόμενο χώρο της τοπικής AI.

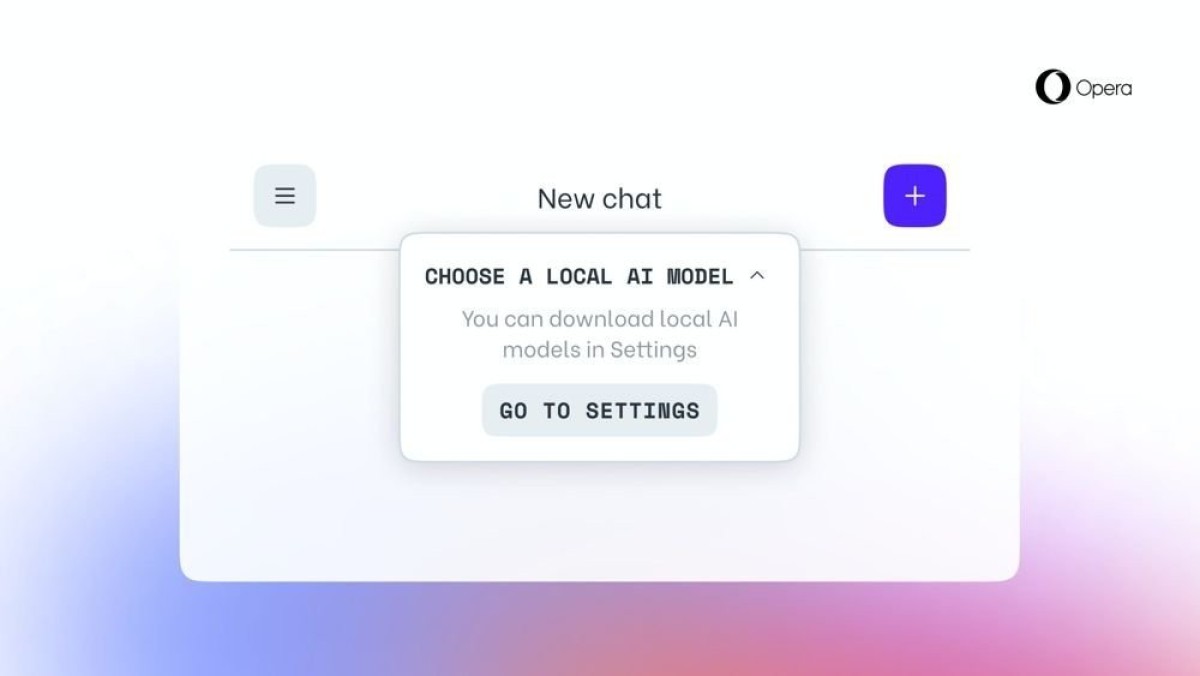

Η Opera αποκαλεί αυτά τα νέα χαρακτηριστικά ως μέρος του "AI Feature Drops Program" και δεσμεύεται ότι τα δεδομένα των χρηστών θα διατηρούνται τοπικά στη συσκευή τους, επιτρέποντάς τους να χρησιμοποιούν την παραγωγική Τεχνητή Νοημοσύνη χωρίς την ανάγκη αποστολής πληροφοριών σε κάποιο server. Η εταιρεία χρησιμοποιεί το open source framework Ollama για να τρέξει αυτά τα μοντέλα στους υπολογιστές των χρηστών. Κάθε παραλλαγή των μοντέλων χρησιμοποιεί μεταξύ 2-10 GB αποθηκευτικού χώρου στο τοπικό σύστημα.

Η Opera καταβάλλει μεγάλη προσπάθεια να ανέβει στο τρένο της Τεχνητής Νοημοσύνης με αυτές τις νέες λειτουργίες, αν και οι τοπικές LLM δεν είναι το πρώτο AI στοιχείο που διαθέτει ο browser. Με το λανσάρισμα του Opera One πέρυσι, η εταιρεία παρουσίασε και το Aria, τον δικό της ενσωματωμένο βοηθό Τεχνητής Νοημοσύνης της.

[Opera]